Problème indexation Google – Comment les résoudre facilement ?

Il y a une chose importante à savoir en SEO. C'est que Google n'indexe pas tous les sites internet.

Eh oui bienvenue dans le petit monde du référencement naturel.

Mais en même temps !

À voir Stratégie de marketing de contenu pour les petites et moyennes entreprises TPE et PME

Le pourcentage du web indexé continue de diminuer d'année en année. Et ce n'est qu'un début.

Avec près de 2 milliards de sites internet sur le net, il serait excessivement coûteux et peu rentable d'indexer toutes les pages possibles du web.

Surtout lorsque près de 10 % des sites internet sont, au pire, des escroqueries et, au mieux, des spams.

Pour les termes de recherche les plus concurrentiels du web, la plupart des utilisateurs ne vont toujours pas au-delà de la première page de Google.

Serait-il même judicieux d'avoir plus de 100 petits liens bleus indexés pour une seule requête ?

Pas vraiment, surtout lorsque 90 % des clics sont dirigés vers les premiers résultats au niveau de ligne de flottaison.

C'est pourquoi la dernière tendance dans l'arsenal de Google est la désindexation du contenu de faible qualité et à faible visibilité.

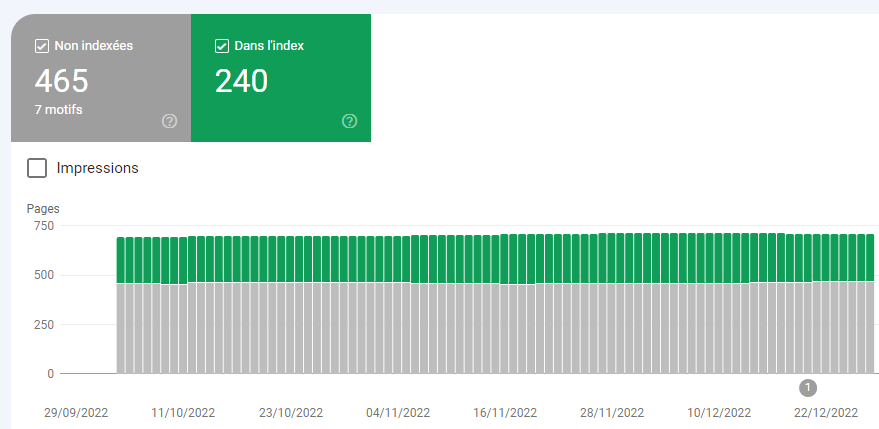

Voici à quoi cela ressemble dans Google Search Console (GSC) sous Indexation >> Pages :

Pourquoi de plus en plus de pages sont-elles désindexées par Google ?

Dans le but de lutter contre le spam, les moteurs de recherche prennent des mesures sévères :

- le contenu de mauvaise qualité

- le contenu créé par des outils d'intelligence artificielle (IA) comme Jasper.ai, Copy.ai et tous les autres qui suivront plus tard

- le contenu difficile à découvrir

- les domaines réaffectés utilisés uniquement pour des liens (PBN)

- le contenu massif et de faible qualité sur des sites à faible autorité de domaine.

La dernière mise à jour du contenu utile (ou la rétrogradation du contenu inutile, comme nous aimons l'appeler) et la mise à jour de SpamBrain sont les combinaisons parfaites pour aider à combattre ce que Google considère comme un mélange massif de contenu Internet dépourvu de véritables apports de qualité pour encourager la consommation.

En d'autres termes, il s'agit de lutter contre un contenu créé pour les moteurs de recherche et non pour les humains.

Le nouveau régime de l'algorithme de classement est particulièrement délétère pour les spécialistes du marketing qui s'engagent dans de lourdes campagnes de création de liens.

Comme Google et d'autres moteurs de recherche continuent à désindexer les pages qu'ils jugent non pertinentes ou spammy, les efforts de création de liens, même de certains sites très connus, sont susceptibles de subir une pression négative à la baisse sur le classement de certains sites.

Pensez à ce que cela donnerait dans la pratique :

Un site possédant des centaines de backlinks de mauvaise qualité subit soudainement une désindexation massive d'un grand pourcentage de son profil de liens, le résultat est simple baisse de son classement.

Pour couronner le tout, les pages situées dans des thématiques similaires à ceux des autres pages désindexées sont plus susceptibles de connaître les mêmes problèmes de désindexation, leur contenu étant considéré comme non pertinent et éliminé de l'index.

La bonne nouvelle, c'est que Google a aussi la gentillesse de vous montrer où se situent vos lacunes, afin que vous puissiez vous adapter en conséquence.

Voici quelques exemples de la CGC :

- Page avec redirection

- Exclu par la balise ‘noindex'.

- Page non trouvée (404)

- Page alternative avec une balise canonique approprié

- Doublon sans balise canonique sélectionnée par l'utilisateur

- Bloqué en raison d'un autre problème 4xx

- Bloqué en raison d'un accès interdit (403)

- Crawlé – actuellement non indexé

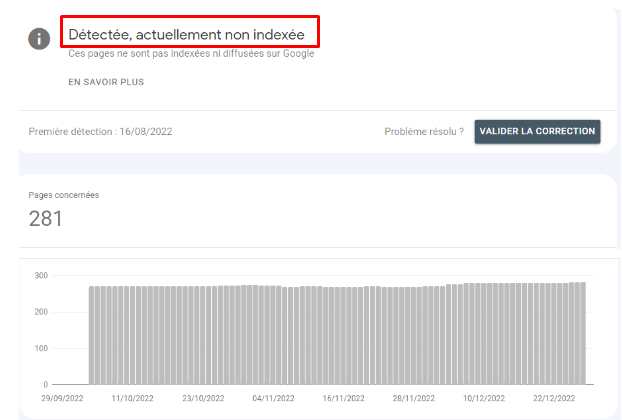

- Découverte – actuellement non indexé

- Erreur de serveur (5xx)

La plupart des problèmes énumérés ci-dessus sont des solutions simples pour un chef de projet SEO qui a un peu de bouteille. N'est ce pas!

Les deux en gras sont un peu plus nuancés et méritent une discussion plus approfondie.

Comment résoudre les problèmes de désindexation de pages ?

Bien que le tableau ci-dessus puisse faire monter votre taux de stress, il existe des solutions pour éviter la désindexation et inverser la tendance à la désindexation de votre site web.

Crawlé – non indexé vs. découvert – non indexé

Lorsque vous soumettez un tout nouveau sitemap à Google, les robots d'exploration du Web peuvent mettre un certain temps avant de parcourir votre plan de site.

Lorsque votre sitemap est exploré, les robots remarquent les pages à explorer, mais il est probable qu'ils n'explorent qu'une petite partie de votre sitemap global à chaque passage.

Un site peut avoir des pages qui sont dans un sitemap (ce qui est une indication claire qu'un webmaster préférerait qu'elles soient explorées et indexées dans les recherches), mais cela ne signifie pas nécessairement cela :

- Les crawlers des moteurs de recherche crawleront à tout moment OU

- Les moteurs de recherche indexeront la page une fois qu'elle aura été explorée.

Les deux graphiques suivants proviennent du même site que celui mentionné ci-dessus, par souci de continuité.

Même lorsque les moteurs de recherche explorent le site, ils peuvent décider de ne pas indexer vos pages :

GSC vous montrera exactement quelles pages ont été explorées, mais pas indexées.

Amélioration de la qualité de votre contenu

Toute solution commence toujours par la qualité de vos ressources de contenu.

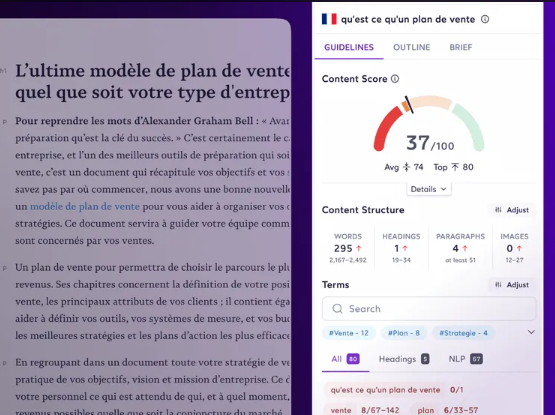

Vous pouvez avoir besoin d'un audit de la qualité du contenu : Surfer SEO

Alors, que certains outils sont censés être des vérificateurs de plagiat AI, d'autres sont meilleurs pour trouver les mots-clés manquants dans le corps de votre texte qui le rendraient comparable et unique.

Semrush et Surfer font un excellent travail en fournissant des options pour la saisie des bons mots-clés LSI (indexation sémantique latente) et d'entité qui seront essentiels pour qu'une page particulière soit statistiquement égale aux autres pages en première position.

En outre, ces outils et d'autres logiciels peuvent vous montrer d'autres façons dont votre page peut être déficiente par rapport à des concurrents mieux classés.

Nous présentons ici les facteurs les plus significatifs d'un point de vue statistique.

Mais les facteurs On Page SEO les plus importants à prendre en compte sont les suivants :

- Le nombre de mots comparables

- LSI et termes d'entité dans le corps de la page

- Nombre total de balises H1 à H6

- Mots clés dans les balises H1 à H6

- Densité globale des mots-clés

- Densité partielle des mots-clés

- Structure de la page (éléments de paragraphe, éléments d'image, etc.)

- Vitesse de chargement de la page.

Si vous avez utilisé un outil d'IA ou ChatGPT pour vous aider à générer des pages, vous devrez effectuer certaines mises à niveau humaines, mais pas nécessairement une réécriture complète du contenu lui-même.

Les bots (et même les personnes) peuvent savoir quand un contenu a été créé à l'aide de GPT-4 ou Bard et d'autres outils de traitement du langage naturel ou d'apprentissage automatique.

Les algorithmes d'apprentissage automatique ne sont peut-être pas capables de découvrir les problèmes de ghostwriting sur Internet, mais ils peuvent découvrir le contenu généré par l'IA.

Un bon éditeur de contenu ou une bonne équipe d'édition peut également être incroyablement utile pour mettre à jour votre contenu, effectuer des modifications et l'améliorer.

Inspecter Google Search Console

Il existe un outil d'analyse manuelle amusant dans Google Search Console

Lorsque vous avez terminé la mise à niveau et la mise à jour de votre contenu, veillez glisser l'URL précise dans le SGC pour que Google l'ajoute à la file d'attente des robots d'exploration.

Votre plan de site placera les éléments nouvellement mis à jour en tête de liste lorsque les robots viendront explorer à nouveau le site, mais il est plus probable que cela accélère le temps nécessaire à une nouvelle exploration et à une réévaluation de la qualité de votre contenu.

Maillages internes

Votre contenu doit pouvoir être découvert par les bots d'exploration des moteurs de recherche.

Si vous ne leur donnez pas les bons signaux, vous continuerez à avoir des pages qui ne sont pas indexées ou qui sortent de l'index.

Créez davantage de liens en utilisant un texte d'ancrage pertinent vers les pages les plus importantes de votre site, en particulier celles que vous voulez faire découvrir, explorer, indexer et classer. C'est aussi simple que cela.

Ce n'est pas parce qu'une page ou un article figure dans votre sitemap que les moteurs de recherche estiment qu'il mérite d'être classé. Vous devez leur montrer ce qui est important.

Faites la promotion de votre contenu

Faites connaître la valeur de votre contenu et de votre site aux influenceurs dans votre secteur.

Remarquez que ce titre ne dit pas “allez créer des liens”.

Si la création de liens peut être utile, c'est aussi une arme à double tranchant en matière de promotion, et le pouvoir des liens ne cesse de diminuer.

Oui, l'établissement de liens est un sous-ensemble de vos efforts de promotion, mais vous devez rester très pointilleux sur l'endroit et la manière dont vos liens entrants sont acquis.

Améliorer la valeur des actifs du contenu

La question que vous devez vous poser en fin de compte est la suivante :

Dans certains cas, et en fonction de l'intention de recherche, le contenu long format de type skyscraper est complètement mort.

Concentrez-vous sur la réponse à une requête spécifique, résolvez un problème réel pour la recherche en ligne de quelqu'un, et faites-le mieux que vos concurrents et vous gagnerez du trafic.

IndexMeNow Review – L'outil SEO qui indexe vos URL en quelques heures !

Vous voulez que vos pages, vos nouveaux domaines et vos backlinks soient indexés rapidement ? Alors il n'y a qu'un seul outil sur le marché qui a un taux de réussite presque garanti.

Alors que la plupart des acteurs du secteur sont confrontés à des problèmes d'indexation, IndexMeNow a permis à ceux qui savent de faire en sorte que tout ce qu'ils veulent soit crawlé, indexé et commence à générer du trafic en moins de 48 heures.

Vous pouvez vous inscrire à IndexMeNow ici, avec mon lien d'affiliation.

==> Obtenez 10% de réduction avec le code promo : MLOCALSEO

Qu'est-ce qu'IndexMeNow ?

IndexMeNow est un outil d'indexation premium qui vous permet d'indexer de nouvelles pages ou de nouveaux liens en une fraction du temps que vous auriez à attendre pour que Google les indexe naturellement.

Comme le montre cette capture d'écran de mes projets IndexMeNow, j'en suis à :

- 487 URLs indexées sur 515 URLs soumises, soit un taux d'indexation de 94.6% !

Comme le montre cette capture d'écran de mes projets IndexMeNow, j'en suis à :

- 487 URL indexées sur 515 URL soumises, soit un taux d'indexation de 94,6% !

La promesse de 90% d'indexation est donc vérifiée dans mon cas. Je précise également que toutes mes pages n'étaient pas de bonne qualité et que certaines ont été indexées sans aucune modification de ma part, alors qu'elles ne l'ont pas été malgré une publication datant de plusieurs mois.

Le service utilise trois méthodologies d'indexation différentes et avancées qui garantissent l'indexation de votre page ou le remboursement intégral de votre crédit.

Qui est Stéphane Madaleno ?

Le créateur d'IndexMeNow est un référenceur français nommé Stephan Madaleno qui possède une grande expérience dans l'industrie du référencement et dans le développement d'outils.

Il a également créé des outils tels que IsIndexed, DataCenter SEO et SEO Hero Ninja.

Avez-vous besoin d'un outil d'indexation ?

Cela dépend!

- Voulez-vous que les nouveaux domaines et les nouvelles pages soient indexés plus rapidement ?

- Avez-vous besoin d'indexer des milliers, des dizaines de milliers ou même des CENTAINES DE MILLIERS d'URL ?

- Voulez-vous accélérer le temps d'action de vos backlinks ?

Dans ce cas, oui ! Et vous avez de la chance car IndexMeNow est le meilleur outil pour cela sur le marché.

Taux de réussite d'IndexMeNow

Le taux d'indexation de 94,6% !

Une demi-douzaine de personnes m'ont répondu, avec des taux de réussite variables

FAQ IndexMeNow

Pourquoi dois-je utiliser un service d'indexation ?

Vous n'en avez peut-être pas besoin, mais il existe de nombreux cas où l'utilisation d'un service d'indexation peut s'avérer extrêmement bénéfique.

Par exemple : De nouveaux domaines qui peinent à être indexés, de nouveaux backlinks que vous ne pouvez pas soumettre vous-même via Google Search Console ou toute une série d'autres raisons.

Comment puis-je savoir si mes liens ont été soumis ?

IndexMeNow dispose d'un vérificateur d'index intégré qui vous dira si et quand Google a indexé votre lien en utilisant l'API isindexed.com.

IndexMeNow crée-t-il des backlinks pour que mes liens soient indexés ?

Non. Ils utilisent 3 méthodes d'indexation distinctes, mais aucune d'entre elles n'inclut la construction de liens vers vos sites ou de backlinks.

IndexMeNow dispose-t-il d'une API ?

Oui, et elle est très facile à utiliser.

Il suffit de le connecter à l'outil de votre choix et de le laisser soumettre des pages automatiquement.

Combien coûte IndexMeNow ?

Il fonctionne sur la base d'un système de crédits, qui commence à 59 $ pour un pack de 60 crédits, ce qui revient à environ 98 c par page.

Pour conclure

Si vous voulez vous classer pour des termes compétitifs, vous devrez travailler page par page de façon minutieuse.

Pour aller plus loin : SEO Technique: 13 Aspects importants d’Optimisations Techniques en Référencement Naturel

Besoin d'aide pour le SEO Local de votre site ? Prendre contact avec nous dès maintenant.