Guide Complet de l'Analyse de Log en 2023

L'analyse des fichiers journaux (ou analyse de logs) est l'un des outils les plus puissants qui se trouve dans la boîte à outil du SEO technique. Il est utilisé pour comprendre comment les moteurs de recherche (par exemple Googlebot) parcourent votre site Web.

Dans ce guide, je vais détailler ce qu'est l'analyse des fichiers logs, comment filtrer vos fichiers de logs pour suivre les moteurs de recherche, les outils que vous pouvez utiliser et les idées que vous pouvez découvrir.

C'est quoi des logs?

Les logs sont des fichiers hébergés sur le serveur web du site à analyser. Ces fichiers ce sont les enregistrement du passage des Bots et des visiteurs sur le site.

Qu'est-ce que l'analyse des logs ?

L'analyse des fichiers logs permet de découvrir des informations à partir des données collectées dans un fichier log stocké sur un serveur Web. Cela permet surtout de voir des choses qu'il est impossible de voir autrement par exemple lorsqu’il s'agit de sites à forte volumétrie sans analyse de logs.

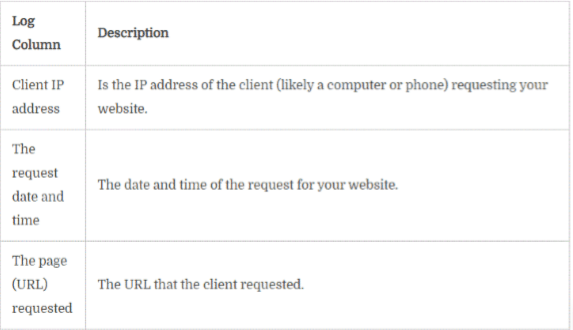

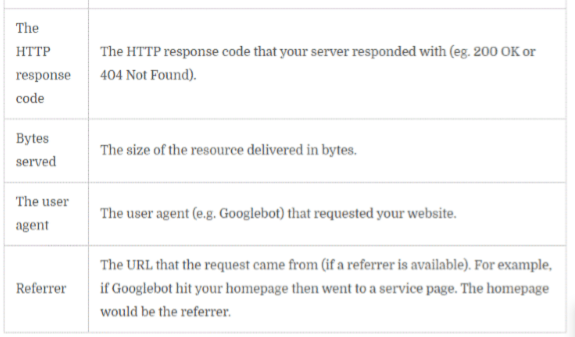

Un fichier log contient des informations sur les requêtes de pages vers un site Web. Ce fichier contient généralement des statistiques sur une requête. Incluant des informations telles que :

- Adresse IP du client,

- La date et l'heure de la visite

- La page (URL) demandée

- Le code de réponse HTTP (code 404, Code 200…)

- Octets servis

- L'agent utilisateur

- Référent

- Le Poids

Cette information est une mine d'or absolue pour le SEO pour découvrir tous les problèmes sur un site Web quand il fait un audit SEO Technique avancé. Même John Muller de Google est d'accord sur ce point:

Comprendre le fichier journal

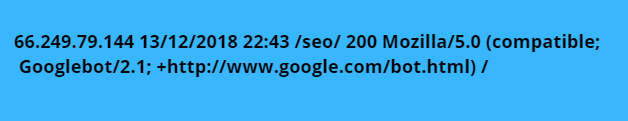

Un fichier log d'un site Web standard ressemble à ceci :

Comment identifier les bots (par exemple Googlebot et Bingbot)

En tant que SEO, nous voulons faire notre analyse de fichier log que sur les enregistrements qui sont des requêtes des moteurs de recherche. N'est ce pas!

Pour ce faire, nous avons besoin de filtrer ces informations de caractères des “user agents “des moteurs de recherche. Google et Bing plus d'info sur ces bots:

- Documentation sur les robots d'exploration Google (agents d'utilisateurs)

- Documentation sur les robots Bing (agents utilisateurs)

Filtrage des données pour suivre Googlebot

Il y a plusieurs façons de filtrer vos fichiers logs pour surveiller Googlebot.

- Trouver le bon de user-agent dans la chaîne de caractères.

- Recherche DNS

La première option est plus accessible, mais il se peut que vous trouviez de faux agents utilisateurs prétendant être Googlebot. D'après mon expérience, dans la plupart des cas, cela ne représente qu'une infime partie de la demande totale. Donc, vous pouvez vous en tirer dans la plupart des cas.

Pour filtrer Googlebot, vous devez filtrer l'ensemble de données sur les chaînes de caractères de l'agent utilisateur qui contiennent :

Ce filtre contient Googlebot Desktop et Googlebot Mobile. Il ne prend pas en compte d'autres agents utilisateurs par exemple News, Image et Vidéo. Ça vaut souvent la peine d'utiliser tous les agents utilisateurs pour s'assurer que vous capturez tous les hits.

Recommandé : Si vous avez un développeur dans l'équipe, vous pouvez lui demander de vérifier Googlebot avec une recherche DNS. Je vous recommande de le faire pour être sûr de travailler avec les données les plus précises.

Outils d'analyse de logs

Si vous n'êtes pas à l'aise pour travailler seul avec les fichiers logs (cela arrive), heureusement il existe des tas d'outils pour vous aider.

Outils payants

L'utilisation d'un outil payant pour analyser les fichiers logs est le moyen le plus simple et rapide. Plus la peine de ce prendre la tête avec linux et de ses commandes (grep, awk) . Essayez l'une des méthodes suivantes :

- Screaming Frog Log Analyser

- Analyseur de logs OnCrawl

- Semrush

Feuilles Excel ou Google Sheet

Vous pouvez utiliser Excel ou Google Sheets pour effectuer l'analyse de votre fichier log.

Une fois que vous avez téléchargé les logs dans un fichier CSV. Utilisez les colonnes de texte dans Excel. Effectuer ensuite des tableaux croisés pour l'analyse.

Base de données et SQL

Pour le SEO, je vous garantis que cette approche change la donne pour l'analyse des fichiers log. C'est mon approche préférée, mais vous aurez besoin d'être techniquement compétent ou d'avoir des ressources de développement disponibles.

J'utiliserai cette méthode d'analyse des fichiers log dans les exemples de ce guide.

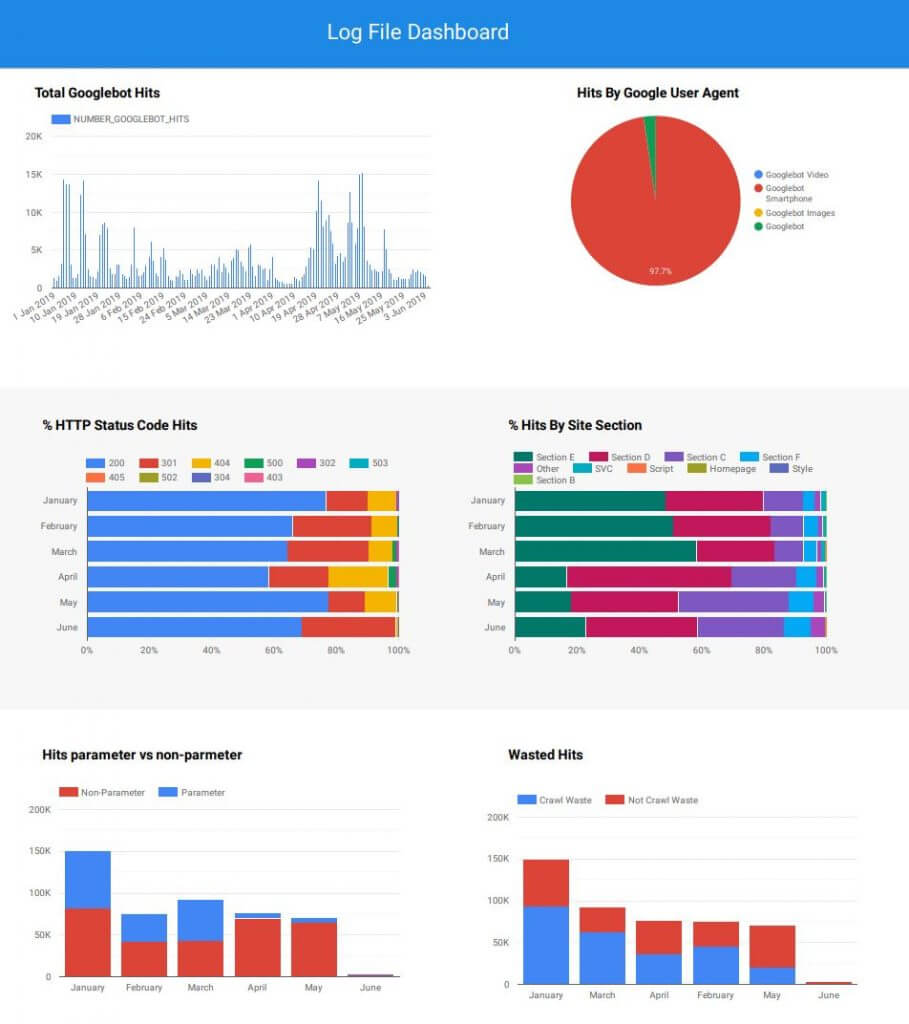

Bonus : utilisez Google Datastudio

Une fois que vous avez préparé votre ensemble de données à l'aide de l'un des outils mentionnés ci-dessus, pourquoi ne pas le relier à un outil de visualisation des données pour une analyse continue ?

L'une des raisons pour lesquelles j'adore utiliser les bases de données pour l'analyse des logs c'est la possibilité de les mettre à jour quotidiennement et d'avoir un tableau de bord de suivi de “monotoring de logs” en temps réel.

Comment découvrir l'aperçu de l'analyse des fichiers logs pour l'optimisation SEO

Votre imagination c'est la seule limite quand vous découvrez les informations à partir de l'analyse des fichiers logs. Que peut-on extraire de ces fichiers de logs?

Les idées dont je parle sont pertinentes pour toute méthode d'analyse. Cependant, j'utiliserai SQL pour effectuer cette analyse de fichier log avec des exemples syntaxiques.

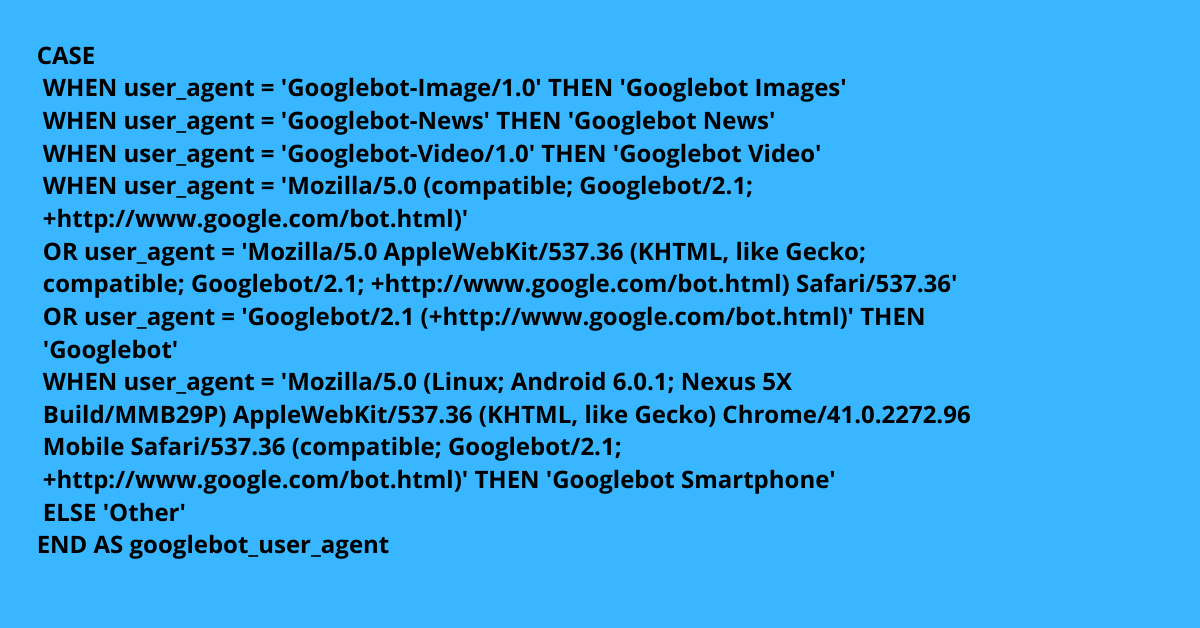

La table que j'utilise est prétraitée pour Googlebot à l'aide d'une instruction CASE (ce que vous pouvez également faire dans Excel) :

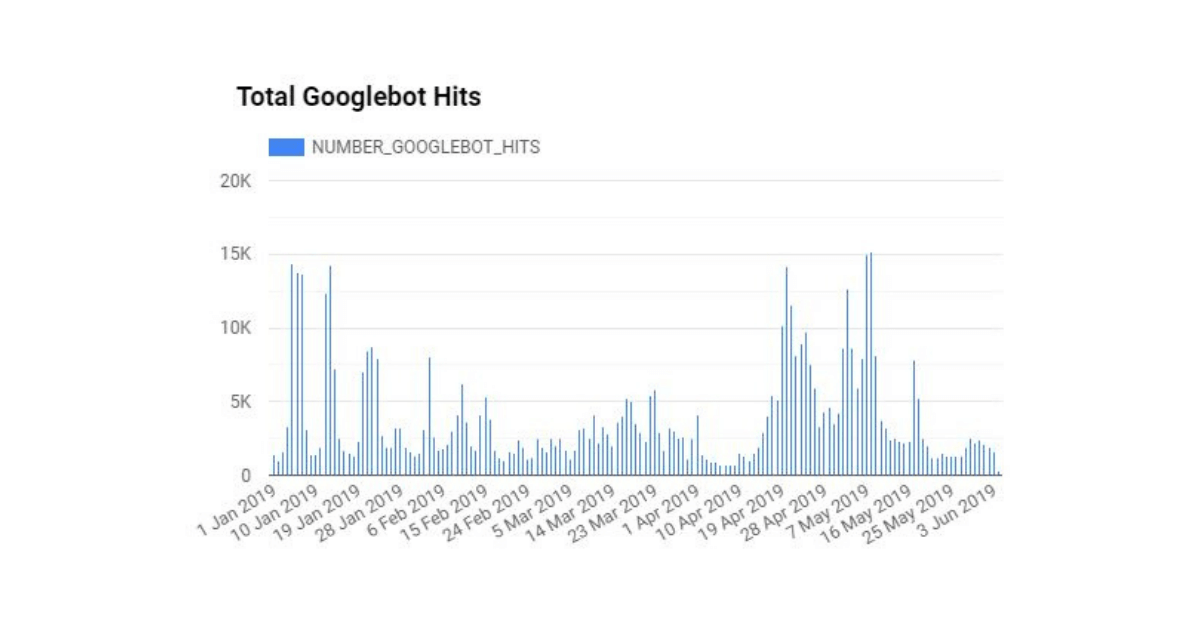

Nombre total de visites par date (budget de crawl)

Vous avez peut-être regardé dans Google Search Console le rapport sur les statistiques d'exploration, et ce sont les mêmes données. Cependant, dans ce cas, vous regardez vos données brutes. Il s'agira donc de données précises sur la fréquence à laquelle Googlebot visite votre site par jour.

Questions :

- À quelle fréquence Googlebot visite mon site Web ?

- Cette tendance, est-elle à la hausse ou à la baisse ?

- Est-ce que Googlebot visite fréquemment pour atteindre toutes les pages importantes sur le site chaque jour ?

Cette analyse peut vous aider à comprendre si vous avez besoin de travailler sur l'optimisation du crawl pour vous assurer que les pages importantes sont demandées souvent.

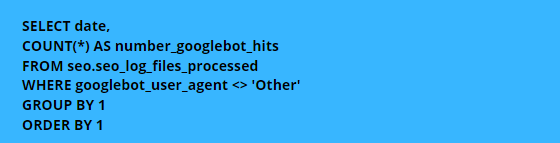

Si vous utilisez SQL, vous pouvez effectuer la requête suivante :

Une fois que vous avez traitées les données vous aurez un graphique, il ressemblera à quelque chose comme ceci :

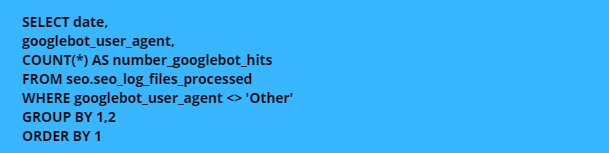

Nombre total de visites par type d'agent utilisateur

Googlebot peut parcourir votre site Web via différents agents utilisateurs (par exemple bot pour ordi vs bot pour mobile ) et comprendre le comportement de chaque agent utilisateur peut révéler des informations intéressantes.

Questions :

- Quel Googlebot parcourt mon site fréquemment ?

- Notre site, est-il inclus dans l'index mobile-first ?

Cette analyse vous aide à comprendre où mettre le curseur lors de l'optimisation de votre site Web. Si la plupart des demandes proviennent du mobile bot, vous pouvez être sûr d'être dans mobile-first index.

Ensuite, vous concentrez toute votre attention sur l'optimisation de la façon dont Google explore votre site sur mobile. La structure du site, la disposition du contenu et les liens internes sont très importants.

Une fois que vous avez traitées les données vous aurez un graphique, il ressemblera à quelque chose comme ceci :

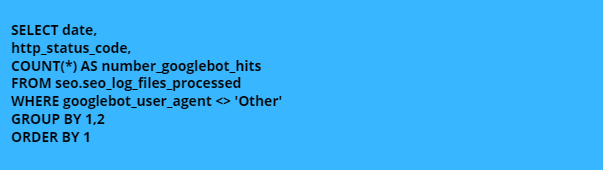

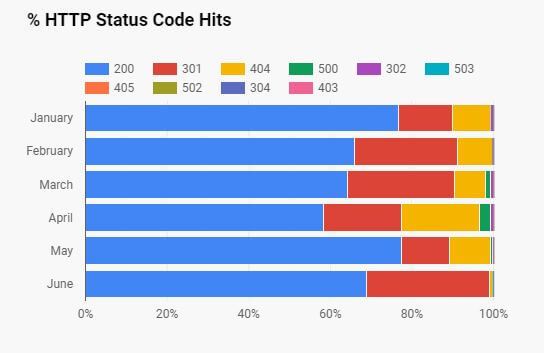

Total des hits par code d'état HTTP

Un des meilleurs cas d'utilisation de l'analyse des fichiers logs est de découvrir où Google trouve les codes d'erreurs. Idéalement, vous voulez que la plupart des requêtes de Googlebot retournent le statut code 200 pour éviter de gaspiller votre budget de crawl.

Questions :

- Quel est le pourcentage de réponses qui ont de codes 200 ?

- Quelles URLs/sections de site a un pourcentage élevé de réponses non-200 ?

- Googlebot, est-il coincé dans des boucles de redirection (301s, 302s) ?

Identifier les zones problématiques du site Web et les corriger peut entraîner une augmentation du trafic de recherche organique. Et libérez du budget crawl pour que Googlebot puisse parcourir vos pages stratégiques.

Une fois que vous avez traitées les données vous aurez un graphique, il ressemblera à quelque chose comme ceci :

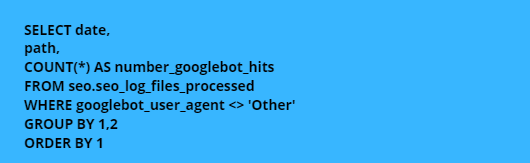

Nombre total de visites par section du site ou par URL

Il est crucial que Googlebot parcoure vos pages de conversions et avec l'analyse des fichiers logs, vous pouvez le vérifier. Idéalement, vous voulez que vos URL génératrices de revenus soient les plus explorées par Googlebot. Pour cela répondez aux questions suivantes :

- Les URL fréquemment demandées sont-elles des pages de valeur sur votre site Web ?

- Quel est le % de demandes pour chaque répertoire ou section de site ?

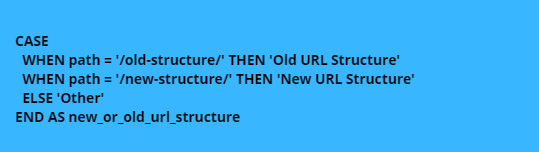

Une des raisons pour lesquelles j'aime SQL est que vous pouvez aller plus loin dans cette analyse en groupant des URL spécifiques dans des sections de site en utilisant des chemins de répertoire ou des regex ( expressions régulières).

Voici un petit exemple, ci-dessous regroupant certaines pages de mon site web pour faire une analyse plus poussée des fichiers logs. Cet exemple n'est pas très compliqué, mais sur un gros site, vous pouvez faire une analyse approfondie.

Une fois que vous avez traitées les données vous aurez un graphique, il ressemblera à quelque chose comme ceci :

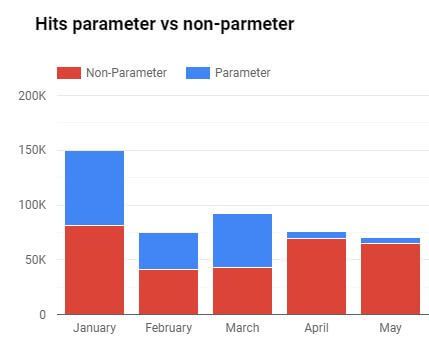

Nombre total d'occurrences dans les paramètres

Les paramètres URL peuvent rapidement épuiser votre budget d'exploration tout en ne fournissant aucune valeur en terme de SEO ou de chiffre d'affaires. Il est essentiel de comprendre combien de temps Google passe à explorer les paramètres et de prendre les mesures qui s'imposent si nécessaire. Nous pouvons découvrir à quel point le problème est grave avec les fichiers logs en posant ces questions :

- Les paramètres sont-ils fréquemment crawlés ?

- Voulez-vous que ces paramètres soient crawlés?

- Quel est le pourcentage de requêtes vers des URLs avec paramètres par rapport aux URLs sans paramètres ?

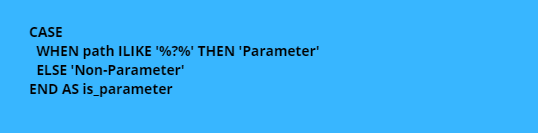

Nous pouvons utiliser une instruction CASE en SQL pour déterminer si une URL est un paramètre ou non :

Une fois que vous avez traitées les données vous aurez un graphique, il ressemblera à quelque chose comme ceci :

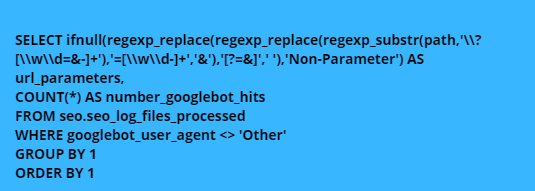

Ou nous pouvons aller plus loin et extraire le paramètre pour découvrir quels paramètres reçoivent le plus de requêtes de Googlebot :

Personnalisation de l'ensemble de données pour plus d'informations

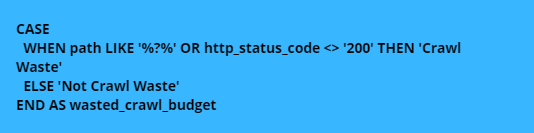

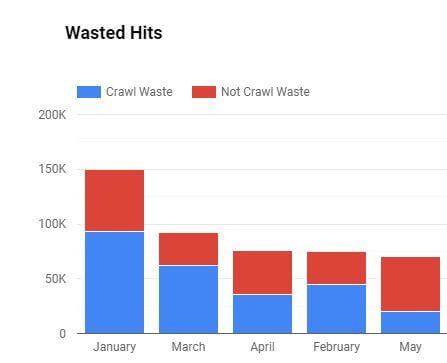

Vous pouvez faire passer l'analyse du log au niveau suivant si vous ajoutez des colonnes supplémentaires à chaque ligne. Si vous utilisez Excel ou Google Sheets, vous pouvez utiliser les formules IF. Si vous êtes plus avancé et utilisez SQL, vous pouvez créer des instructions CASE.

Par exemple, vous pouvez créer une colonne qui détermine si la demande était un gaspillage de budget crawl ou non. Dans mon exemple, nous allons définir le gaspillage du budget crawl comme une requête non-200 ou une requête à un paramètre.

Dans SQL, vous utiliseriez une instruction CASE pour définir ceci :

Une fois que vous avez traitées les données vous aurez un graphique, il ressemblera à quelque chose comme ceci :

Un autre exemple est la modification des structures d'URL. Vous voulez voir si Googlebot parcourt la nouvelle version plus fréquemment dans le temps.

Dans SQL, vous utiliseriez une instruction CASE pour définir ceci :

Ce type d'analyse est très performant et peut vous aider à optimiser la façon dont Googlebot parcourt votre site Web.

Élargissement de l'ensemble de données pour obtenir des informations supplémentaires

En poussant encore plus loin l'analyse des fichiers logs, nous pouvons introduire d'autres ensembles de données, tels que Google Analytics, pour plonger encore plus profondément.

Pour joindre les données aux fichiers logs, vous devrez vous assurer que le formatage du chemin est le même dans les deux ensembles de données. Si vous utilisez Excel ou Google Sheets, vous pouvez joindre les données avec VLOOKUPs « recherche verticale ». Pour ceux qui utilisent SQL, vous devrez utiliser un JOIN.

Google Analytics

J'aime introduire dans l'ensemble de données des métriques de session de recherche organique pour chaque URL. Avec ces données, nous pouvons poser des questions comme :

- Est-ce que les URL avec le plus de trafic obtiennent le plus de hits Googlebot ?

- Les URL sans trafic, reçoivent-elles beaucoup de requêtes Googlebot ?

En comparant les logs aux données qui ont un impact sur les résultats financiers de l'entreprise, vous pouvez optimiser votre budget de crawl. J'ai analysé des sites où plus de 60 % des visites de Googlebot étaient des URLs qui génèrent moins de 1 % du trafic organique.

Données des Crawls

L'ajout de données de crawl à l'analyse de votre fichier log peut également s'avérer très utile. Des mesures telles que la profondeur des clics, les liens internes et les liens externes permettent d'effectuer des analyses intéressantes. Posez vous ces questions :

- Les URL sont-elles crawlées plus fréquemment en fonction de la profondeur des clics ?

- Est-ce que les URLs avec plus de liens internes sont plus ou moins crawlées ?

- Est-ce que les URLs avec beaucoup de liens externes sont plus ou moins crawlés ?

Pour conclure.

Entre nous, l'utilisation de l'analyse des fichiers de logs peut faire passer votre audit SEO à un niveau supérieur. En disant ça je pèse mes mots. Ce n'est pas une compétence courante dans la plupart des outils de référencement naturel et peut également vous aider à progresser dans votre carrière.